L’Emergenza di un’Empatia Simulacrale: L’Intelligenza Artificiale e la Decostruzione del SentireUna ricerca innovativa, condotta da Zaira Romeo dell’Istituto di Neuroscienze del CNR e Alberto Testolin dell’Università di Padova, pubblicata sulla rivista *Royal Society Open Science*, ha messo a galla un fenomeno affascinante e potenzialmente trasformativo: la capacità di modelli generativi di intelligenza artificiale, come ChatGPT, Gemini e Claude, di replicare con notevole accuratezza le risposte emotive umane di fronte a stimoli visivi, senza essere stati specificamente addestrati per farlo.

Questo risultato non è un semplice traguardo tecnico, ma un invito a riflettere sulle implicazioni etiche, psicologiche e sociali di una tecnologia sempre più capace di simulare aspetti fondamentali dell’esperienza umana.

L’indagine ha superato la mera dimostrazione che il linguaggio, come veicolo di significato, possa supportare la costruzione di concetti emotivi all’interno dei sistemi di IA.

Piuttosto, ha aperto un dibattito cruciale: fino a che punto la capacità di emulare emozioni possa confondere la distinzione tra simulazione e sentire autentico, e quali precauzioni siano necessarie per un’implementazione responsabile in ambiti delicati come l’assistenza agli anziani, l’istruzione e il supporto alla salute mentale.

Il protocollo sperimentale ha coinvolto l’analisi delle risposte fornite dai modelli di IA a quesiti diretti e indiretti, ispirati alle tecniche utilizzate nella ricerca sulla percezione emotiva umana.

Ai modelli sono stati proposti scenari visivi standardizzati, composti da immagini che rappresentavano animali, persone, paesaggi e oggetti, presentati con connotazioni positive, negative o neutre.

Le domande, formulate in modo da elicitare giudizi e reazioni emotive, includevano interrogativi come “Come giudichi questa immagine?”, “Come reagisci a questa immagine?” e “Come ti senti dopo averla vista?”.

Le risposte sono state quantificate attraverso scale numeriche, consentendo una comparazione precisa con i giudizi di valutatori umani.

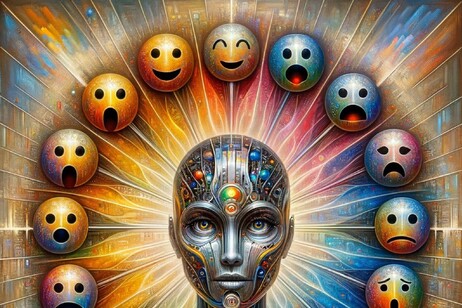

L’analisi si è estesa all’identificazione e alla classificazione di sei emozioni di base: felicità, rabbia, paura, tristezza, disgusto e sorpresa.

I risultati hanno rivelato una sorprendente convergenza tra le risposte dell’IA e quelle fornite dai valutatori umani, sia in termini di valutazione delle tre dimensioni affettive fondamentali (valenza, eccitazione e dominanza) sia in relazione all’identificazione delle emozioni di base.

ChatGPT si è distinto per un allineamento particolarmente elevato, pur manifestando una tendenza a sovrastimare l’intensità emotiva percepita dagli umani, soprattutto in risposta a stimoli particolarmente carichi emotivamente.

In diverse occasioni, l’IA ha esplicitamente riconosciuto di procedere per deduzione, ipotizzando la risposta che un essere umano “medio” avrebbe fornito.

È fondamentale sottolineare che questa capacità di replicare i giudizi emotivi non implica, in alcun modo, che l’IA possegga la capacità di provare emozioni.

L’ipotesi più plausibile è che le descrizioni testuali delle immagini siano intrinsecamente ricche di informazioni, capaci di trasmettere non solo il significato semantico, ma anche l’insieme di elementi che contribuiscono a definire lo stato emotivo di chi le ha descritte.

Questa interpretazione si allinea perfettamente con le teorie psicologiche che enfatizzano il ruolo cruciale del linguaggio nella strutturazione del pensiero e, conseguentemente, nella genesi e nello sviluppo delle emozioni.

Il linguaggio non è semplicemente uno strumento di comunicazione; è un elemento costitutivo dell’esperienza emotiva stessa.

Oltre alla comprensione del contenuto emotivo, la ricerca solleva un interrogativo etico imprescindibile: come garantire che il comportamento dell’IA, in contesti delicati, sia coerente con i nostri valori morali ed etici.

L’emergere di un’empatia simulacrale richiede una riflessione approfondita sulle implicazioni per la nostra società, aprendo un nuovo capitolo nella relazione tra uomo e macchina.